questionet

LLM Trend Note (1) 본문

안녕하세요 여러분:) LLM Trend Note1 에 오신걸 환영합니다!

최신 트렌드라는 게 따라가자니 어디서부터 시작해야할지 막막하고,

보고 있자니 이 기술이 앞으로도 유효할지 모르겠고,

아마 이 노트에서도 시간을 들여 숙고해볼 만한 가치가 없는 내용이

여러분들께서 노트를 보시게 될 시점엔 많아지게 되는 건 아닐까

저 역시 한편으론 걱정이 되기도 합니다.

이 노트를 작성하기 위해 자료를 수집하는 동안에도 closed source가 open되기도 했고

이런 자료가 있었으면 좋겠다 싶은 것들이 다음 날에 짠 하고 공개되곤 했으니까요.

하지만 다른 한편으로 트렌드란

오랜 시간의 압력으로 굳어져 크게 변할 수 없어 보이는 현상이나

현재까지 이룩한 문명의 힘으로 규정지어진 기술적, 사회적 사실들로부터 생겨나고 바뀌는 것이기도 하지요.

그래서 우리는 아래에 적은 몇가지 fact로부터 출발해보고자 합니다.

Fact 1.

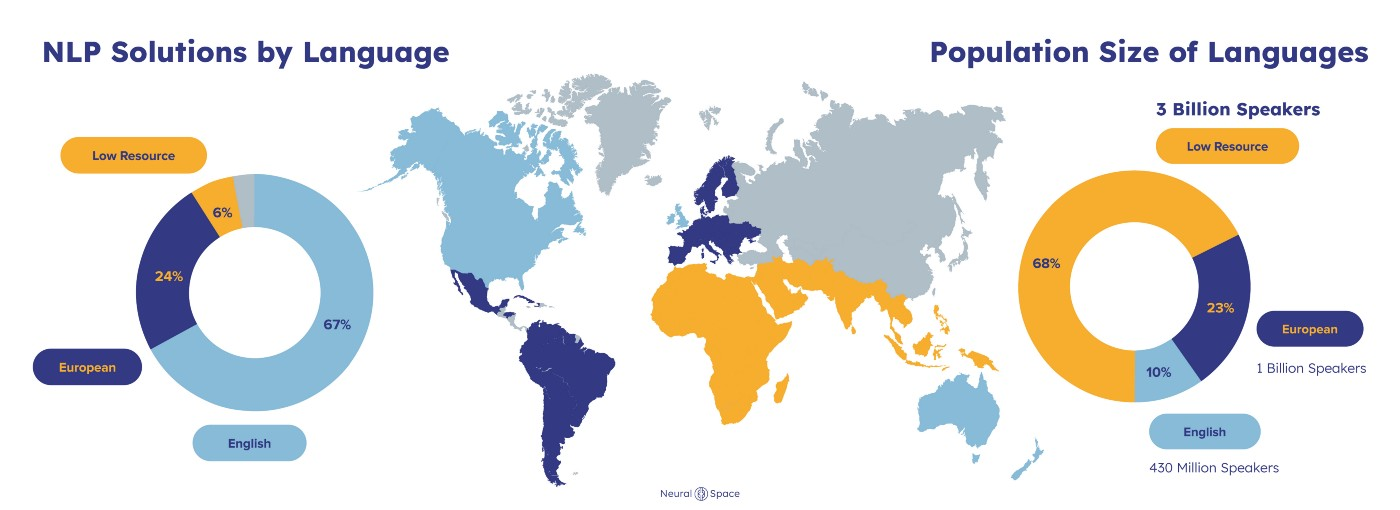

전 세계에서 사용되는 언어에 대한 각종 통계를 발표하는 에스놀로그에 따르면

2022년 기준 지구상엔 7168개의 언어가 있다고 합니다.

그 중에서 한국어는 사용자 수 기준 20위권 안팎에 있다고 기록되어 있습니다.

그런데 2023년 3월 14일 OpenAI가 발표한 GPT-4에 따르면,

한국어는 아프리카에서 쓰는 스와힐리, 영국 웨일스 지방의 언어인 웰시와 함께 low resource language로 분류됩니다.

Fact 2.

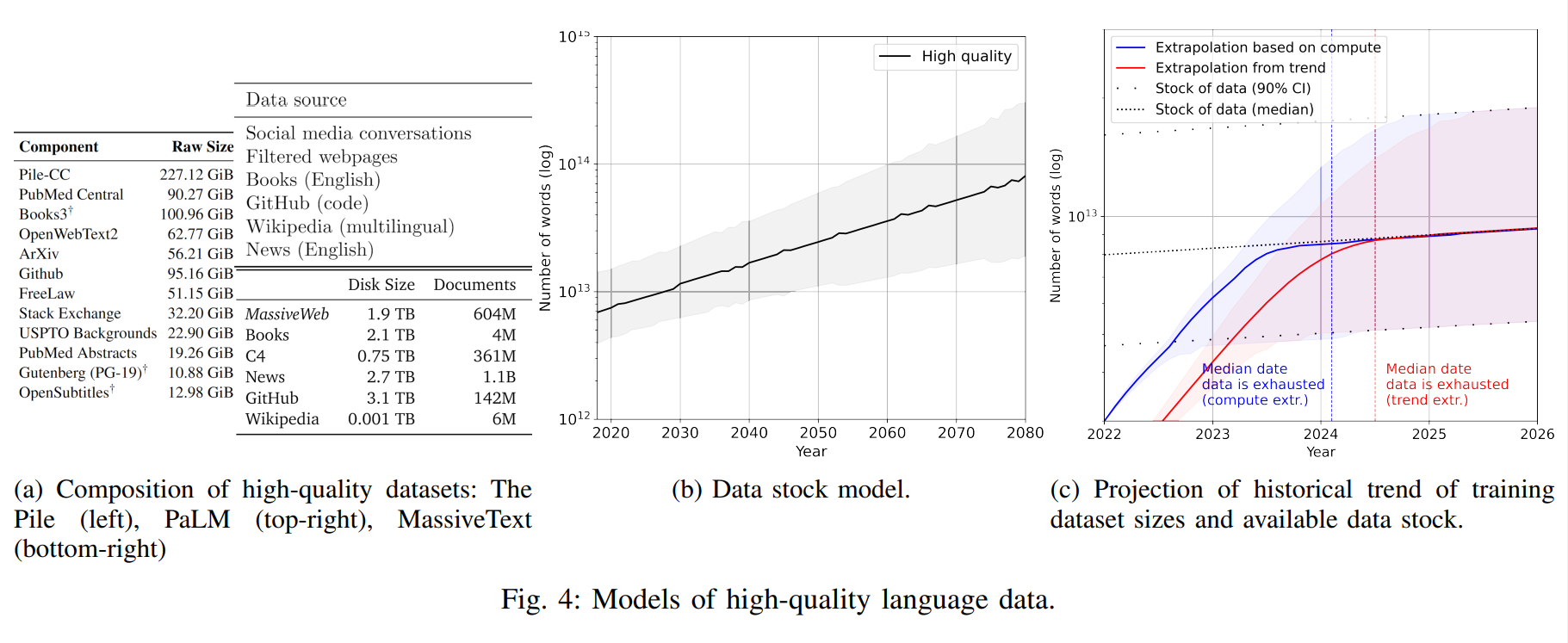

2022년 10월에 발표된

Will we run out of data? An analysis of the limits of scaling datasets in Machine Learning

이라는 흥미로운 제목의 논문에 따르면, 전 세계의 디지털화 된 고품질 텍스트 데이터의 총 재고,

다시 말해 전세계 NLP 개발자 및 연구자들이 모델 학습에 쓸 수 있는 사용 가능한 총 토큰 개수가

4조 6000억에서 17조 2000억 개 사이로 추정된다고 합니다.

또 다른 출처에 의하면 그보다 훨씬 적은 약 3.2조개의 토큰으로 추산된다고도 하네요!

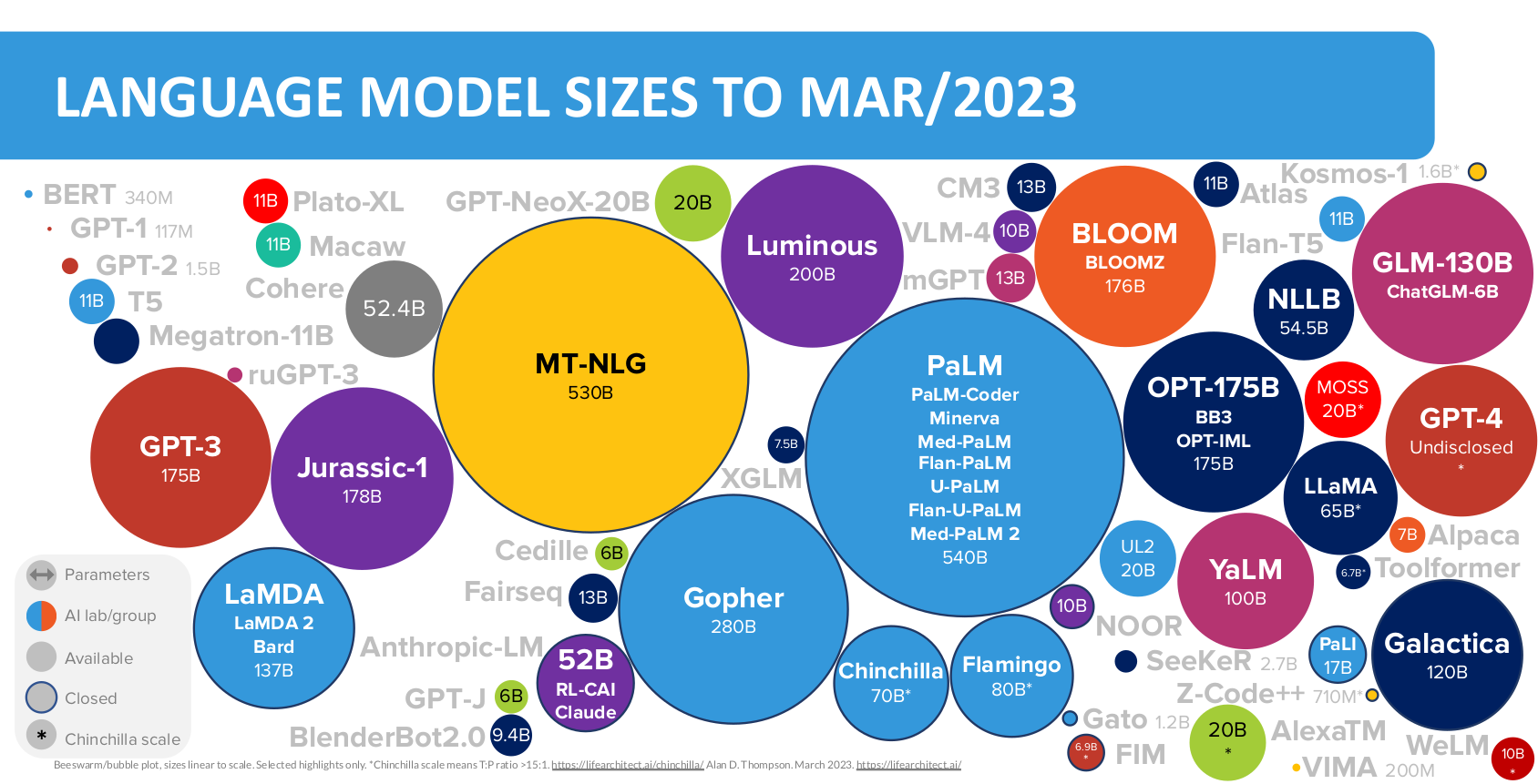

그런데 2023년 3월 현재 가장 핫한 OpenAI의 GPT-4와 더불어 주목받고 있는 Large Language Model(이하 LLM)인

Meta의 LLaMA가 pre-train을 하는데 사용한 토큰의 개수는 자그마치 1.4T (1조 4천억) 개라고 합니다.

잠깐 정리해 볼까요?

- 전세계 7천여 개 언어 가운데 사용자 수로 치면 20등 정도 하는 한국어가,

LLM 관점에선 그다지 풍부한 자원의 언어가 아니다. - LLM을 학습하는 데 사용가능한 고품질 토큰이 수조 개 가량 있는데,

최신 LLM은 해당 총 토큰 개수의 최대 1/4에 달하는 양을 학습하고 있다.

안타깝게도 지금 이 글을 쓰는 시점에선 chatGPT의 LM으로 쓰인 GPT3.5 및 GPT-4가

구체적으로 어떤 언어들을 몇개나 학습했는지 공개되지 않았습니다.

대신 자료가 공개된 모델 중 참고해 볼만한 가장 최신 모델이 있습니다.

2022년 4월에 발표된 Google의 PaLM은 5천 400억 개 파라미터를 가진 현재 시점 기준 가장 큰 모델입니다.

이 PaLM 이란 모델이 학습에 사용한 토큰 개수는 총 7천 800억개입니다.

여기서 한국어 토큰은 약 0.2%를 차지합니다. 참고

자, 여기서 우리는 어떤 생각을 이어나가 볼 수 있을까요?

최신 모델 아키텍쳐와 분산학습 기술이 발전함에 따라 LLM의 모델 사이즈는 앞으로 더욱더 커질 수 있습니다.

또는 훨씬 더 좋은 성능을 내면서도 모델 사이즈는 줄어드는 쪽으로도 발전할 수 있겠죠.

어느 쪽이든 디지털 토큰의 총량을 다 먹어치우는 날은 머지 않아 도래할 것입니다.

전 세계 인구 수와 증감률, 인터넷 유저 수와 보급률의 추이를 통해 예상할 수 있는 시나리오지요.

대한민국의 출산율은 OECD 회원국 중 유일하게 1명대 아래입니다.

정확히는 2013년부터 2022년까지 10년간 출산율 최하위를 기록하고 있습니다.

(2007년, 2012년 두 해만 꼴찌에서 두 번째)

(출처 : https://www.pressian.com/pages/articles/2023022215021464370)

반면, UN에 따르면 세계인구 수는 2022년 11월 기준 80억명을 돌파했고,

향후 80년간 110억명 대에 이를 것으로 추산합니다.

(출처 : https://ko.wikipedia.org/wiki/%EC%84%B8%EA%B3%84_%EC%9D%B8%EA%B5%AC)

한편, 전 세계의 7,000여개 언어 중 보존을 위한 조치를 하지 않으면

향후 100년 내에 당장 소멸 위기에 처한 언어가 1,500 여개에 달한다고 합니다.

(출처 : http://thescienceplus.com/news/newsview.php?ncode=1065613046395135)

이런 저런 통계량들을 종합해보면, Language Modeling을 위한 학습 데이터를 구성할 때,

한국어를 위시한 low resource language의 경우 심각한 불균형을 유지할 것이라고 말할 수 있습니다.

더불어 현재 이후 발표될 최신 모델들은 이 불균형한 학습 데이터 비율 구조에서 크게 벗어나지 않은 상태로

학습 가능한 모든 토큰을 학습하게 될 것이라고도 말해볼 수 있을 것 같습니다.

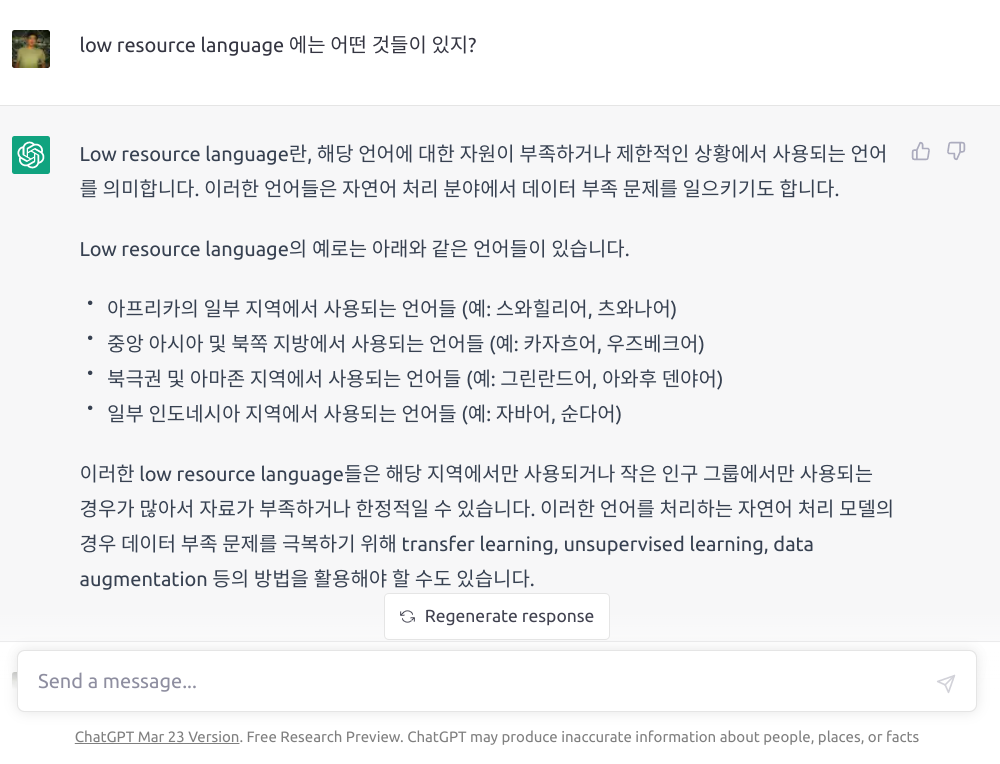

그럼에도 불구하고, 2023년 3월 기준 chatGPT에게 low resource language인 한국어로 질문을 했을 때

아래와 같이 꽤 괜찮은 한국어 답변을 내놓는 것을 볼 수 있습니다.

이러한 현실이 한국어로 NLP를 연구하며 서비스하는 사람들에게 어떤 의미를 지니고,

어떤 도전을 요구하는지에 관해선 이 노트의 마무리에 함께 생각해보도록 하겠습니다.

저렇게 엄청난 크기의 모델 안에 어떤 능력들이 숨어 있는 걸까요?

그 능력들을 가능하게 하는 기술들은 무엇일까요?

반대로 반드시 저렇게 거대한 모델이어야만 좋은 성능을 발휘하는 걸까요?

오늘 이 시간 대표적인 최신 LLM 모델과 그 아키텍쳐 및 학습기법들을 살펴보면서

위 질문들에 대한 힌트를 얻어볼 수 있게 되면 좋겠습니다.

나아가 현재 어떤 흐름으로 NLP가 흘러왔고 흘러가게 될지 헤아려 볼 수 있는 시간이 되시길 바래봅니다.

다음 노트에서부터는

본격적으로 LLM의 등장배경과 최신 LLM의 성능에 미치는 핵심 기술들 및

당면한 문제와 한계를 파악하고 전망해보도록 하겠습니다.